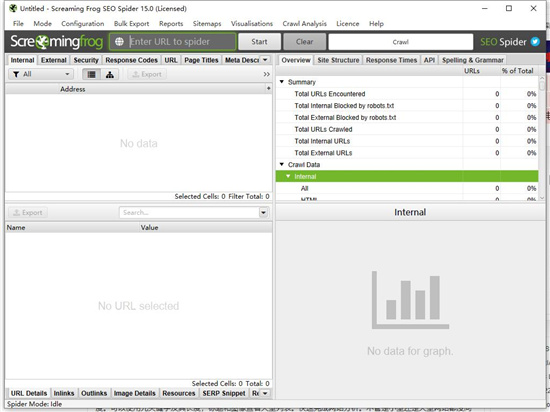

Screaming Frog SEO Spider 15中文破解版-网站爬虫软件下载 v15.0(附注册机)

Screaming Frog SEO Spider 15是一款功能超强且专业的网站爬虫软件,该软件可以用合适的硬件、内存和存储设备抓取数百万个URL。它可以将爬网数据保存在数据库的RAM或磁盘中,是为了帮助用户快速抓取网站的网址,并获取关键元素,分析网址,查看地址、内容类型、状态码、标题、元描述、关键字、大小、字数、级别、哈希和外部输出链接等,检测许多个网页链接的响应时间,查看网页标题以及它们的出现次数、长度和像素宽度。您可以使用元关键字及其长度、标题和图像来查看大型列表,快速完成网站分析。不管是小网站还是大网站,都没关系,您可以实时分析结果并快速收集数据,这样SEO就可以做出最明智的决策。Screaming Frog SEO Spider 15破解版可以获取的最大URL数取决于分配的内存和存储。这是最简单和最快的方式来收集一个网站的搜索引擎优化信息,它还可以生成多个报告,并导出到硬盘的信息。本来分享的是破解版,文件中包含了注册机,激活后可以永久免费使用,有需要的朋友可以来下载试试。

安装破解教程

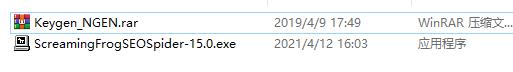

1、在知识兔下载并解压,得到ScreamingFrogSEOSpider-11.0.exe安装程序和Keygen.exe注册机

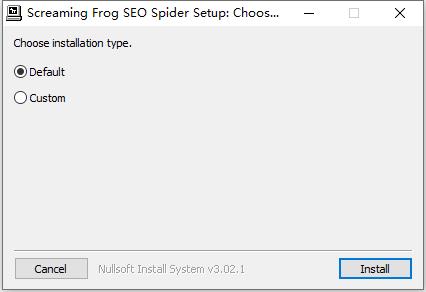

2、知识兔双击ScreamingFrogSEOSpider-11.0.exe运行,知识兔选择安装路径,知识兔点击next

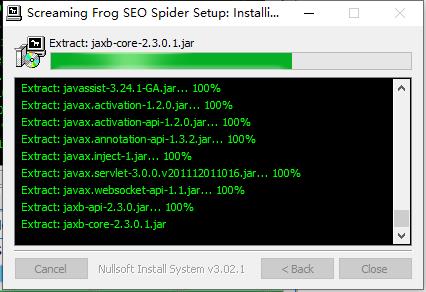

3、安装中,稍等一会儿

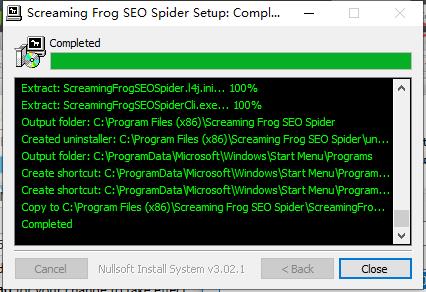

4、安装完成,知识兔点击close关闭向导

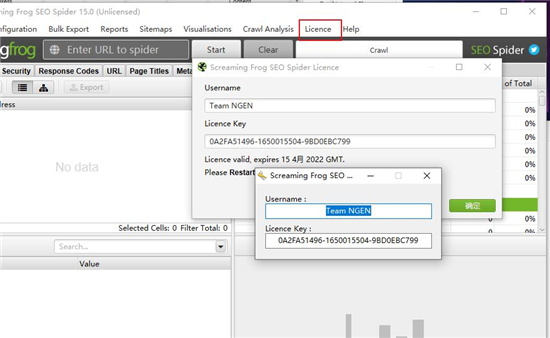

5、运行软件和keygen注册机,将注册机中的注册信息对应复制到软件中

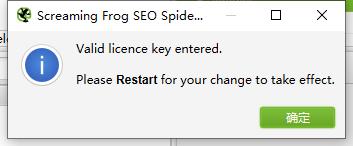

6、注册成功,重启软件

软件优势

1、查找断开的链接,错误和重定向

2、分析页面标题和元数据

3、查看Meta机器人和指令

4、审计hreflang属性

5、发现重复页面

6、生成XML站点地图

7、网站可视化

8、抓取限制(无限)

9、调度

10、抓取配置

11、保存抓取并重新上传

12、自定义源代码搜索

13、自定义提取

14、Google Analytics集成

15、搜索控制台集成

16、链接度量标准集成

17、渲染(JavaScript)

18、自定义robots.txt

19、AMP爬行和验证

20、结构化数据和验证

21、存储和查看原始和呈现的HTML

功能特色

1、找到断开的链接

立即抓取网站并找到损坏的链接(404s)和服务器错误。批量导出错误和源URL以进行修复,或发送给开发人员。

2、审核重定向

查找临时和永久重定向,识别重定向链和循环,或上传URL列表以在站点迁移中进行审核。

3、分析页面标题和元数据

在抓取过程中分析页面标题和元描述,并识别网站中过长,短缺,缺失或重复的内容。

4、发现重复内容

使用md5算法检查发现完全重复的URL,部分重复的元素(如页面标题,描述或标题)以及查找低内容页面。

5、使用XPath提取数据

使用CSS Path,XPath或regex从网页的HTML中收集任何数据。这可能包括社交元标记,其他标题,价格,SKU或更多!

6、审查机器人和指令

查看被robots.txt,元机器人或X-Robots-Tag指令阻止的网址,例如’noindex’或’nofollow’,知识兔以及规范和rel =“next”和rel =“prev”。

7、生成XML站点地图

快速创建XML站点地图和图像XML站点地图,通过URL进行高级配置,知识兔包括上次修改,优先级和更改频率。

8、与Google Analytics集成

连接到Google AnalyticsAPI并针对抓取功能获取用户数据,例如会话或跳出率和转化次数,目标,交易和针对目标网页的收入。

9、抓取JavaScript网站

使用集成的Chromium WRS渲染网页,知识兔以抓取动态的,富含JavaScript的网站和框架,例如Angular,React和Vue.js.

10、可视化站点架构

使用交互式爬网和目录强制导向图和树形图站点可视化评估内部链接和URL结构。

使用帮助

一、爬行

1、抓取一个网站(子域)

在常规爬网模式下,将抓取您输入的子域,并将其遇到的所有其他子域默认为外部链接(这些子域显示在“外部”选项卡下)。

例如,通过在顶部的“输入蜘蛛网址”框中输入并单击“开始”,尖叫青蛙 www。子域名将被抓取。

在软件的许可版本中,您可以调整配置以选择爬网网站的所有子域(如果知识兔有多个)。如果知识兔您从根开始抓取,默认会抓取所有子域。

最常见的用途之一是在网站上发现错误,例如链接断开,重定向和服务器错误。请阅读知识兔的指南,了解如何查找损坏的链接,解释如何查看404s等错误来源,并将源数据批量导出到电子表格中。

为了更好地控制您的抓取,请通过抓取子文件夹来使用您网站的网址结构,配置选项,例如仅抓取HTML(图片,CSS,JS等),排除功能,自定义robots.txt,包含功能或者更改的模式并上传要爬网的URL列表。

2、抓取一个子文件夹

默认情况下,工具从子文件夹路径向前爬行。只需输入完整的子文件夹URL即可对其进行抓取。

例如,如果知识兔它是博客,可能是。通过直接将其输入,它将抓取/ blog /子文件夹中包含的所有URL。

默认情况下,您可能会注意到某些不在/ blog /子文件夹中的URL也会被抓取。这将是由于“ 检查开始文件夹之外的链接 ”配置。

这种配置允许将它的抓取集中在/ blog /目录中,但是当它们从内部链接时,仍然抓取不在此目录中的链接。但是,它不会再向前爬行。这很有用,因为您可能希望找到位于/ blog /子文件夹中但在URL结构中没有/ blog /的断开链接。要仅使用/ blog /抓取网址,只需取消勾选此配置即可。

如果知识兔子文件夹的末尾没有尾部斜杠,例如’/ blog’而不是’/ blog /’,则不会将其识别为子文件夹并在其中进行爬网。如果知识兔子文件夹的尾部斜杠版本重定向到非尾部斜杠版本,则同样适用。

要抓取此子文件夹,您需要使用include功能并输入该子文件夹的正则表达式(在此示例中为。* blog。*)。

如果知识兔您有一个更复杂的设置,如子域和子文件夹,您可以指定两者。例如到Spider the .de子域和UK子文件夹等。

3、抓取网址列表

通过输入网址并知识兔点击“开始”来抓取网站,您可以切换到列表模式,然后知识兔粘贴或上传特定网址列表进行抓取。

例如,在审核URL和重定向时,这对于站点迁移特别有用。知识兔建议您阅读知识兔的“ 如何审核网站迁移中的重定向 ”指南,知识兔以获得最佳方法。

如果知识兔您希望以列表模式导出数据的顺序与上传的数据相同,则使用“导出”按钮,该按钮出现在用户界面顶部的“上传”和“开始”按钮旁边。

导出中的数据将采用相同的顺序,并包含原始上传中的所有确切URL,知识兔包括重复或执行的任何修复

4、爬行更大的网站

如果知识兔您希望执行特别大的爬网,知识兔建议首先增加的RAM内存分配。

如果知识兔您收到“此内存已用完此爬网”警告,则需要保存爬网,增加RAM分配并考虑切换到数据库存储模式以保存到磁盘,知识兔打开爬网并恢复爬网。

可以抓取的URL数量减少到计算机上可用的内存量以及是否已分配,知识兔以及是否在默认内存存储或数据库存储模式下进行爬网。

5、数据库存储模式

对于非常大的爬网,请阅读知识兔关于如何抓取大型网站的指南,其中分享了可用选项的概述。

您可能希望考虑将爬网拆分为较小的部分,并使用配置来控制爬网。一些选项包括 –

如上所述,通过子域或子文件夹进行爬网。

使用包含功能缩小爬网范围,或使用排除或自定义robots.txt功能排除不需要抓取的区域 。

考虑通过爬网的总URL,查询字符串参数的深度和数量来限制爬网。

通过在的配置中取消图像,CSS,JavaScript,SWF和外部链接,只考虑抓取内部HTML 。

这些都应该有助于节省内存并将爬行集中在您需要的重要区域。有关如何抓取大型网站的详细信息,请参阅知识兔的更多深入指南。

二、保存和上传抓取

在该工具的许可版本中,您可以保存爬网并将其打开回。这些文件保存为特定于的.seospider文件类型。

您可以通过停止并选择“文件>保存”来中途保存爬网。

要打开爬网,只需知识兔双击相关的.seospider filder,知识兔选择“文件>打开”或在“文件>打开最近”下选择一个最近的爬网。然后知识兔,如果知识兔在中途保存,您可以恢复抓取。

请注意,保存和打开抓取可能需要几分钟或更长时间,具体取决于抓取的大小和数据量。

三、组态

在该工具的许可版本中,您可以保存默认爬网配置,并保存配置文件,可在需要时加载。

要将当前配置保存为默认值,请选择“文件>配置>将当前配置保存为默认值”。

要保存配置文件以便以后加载,请单击“文件”>“另存为”并调整文件名(理想情况下为描述性内容!)。

要加载配置文件,请单击“文件”>“加载”并选择配置文件,或选择“文件>加载最近”以从最近的列表中进行选择。

要重置回原始的默认配置,请选择“文件>配置>清除默认配置”。

四、调度

您可以安排抓取在自动运行,作为一次性或选定的间隔。此功能可在应用程序中的“文件>计划”下找到。

您可以预先选择模式(蜘蛛或列表),保存的配置以及API(Google Analytics,Search Console,Majestic,Ahrefs,Moz)来提取计划抓取的所有数据。

您还可以自动保存爬网文件,并将任何选项卡,批量导出,报告或XML站点地图导出到选定位置。

为预定的爬网启动了一个新的实例。因此,如果知识兔爬网重叠,则多个实例将同时运行,而不是在上一次爬网完成之前有延迟。因此,知识兔建议您适当考虑系统资源和爬网时间。

请注意 – 当计划导出数据时,将以无头模式运行(意味着没有接口)。这是为了避免任何用户交互或从您面前开始的应用程序和单击选项,这有点奇怪。

此调度在用户界面内,如果知识兔您更喜欢使用命令行来操作,请参阅知识兔的命令行界面指南。>

下载仅供下载体验和测试学习,不得商用和正当使用。